ベズーの定理の証明

定理

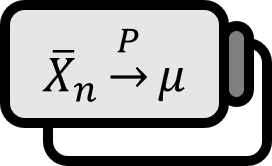

もし$T \left( \mathbf{X} \right)$が完結統計量であり、最小十分統計量でもあるなら、$T \left( \mathbf{X} \right)$は全ての補助統計量と独立である。

説明

バスの定理は、十分統計量に関する定理の中で最も重要なものの一つであり、ある二つの統計量が独立であることを示すことができる非常に強力な結果を導出することができる。直感的に、十分統計量はパラメータ$\theta$についての全ての情報を持っており、補助統計量は$\theta$に依存していないため、当然独立しているように思えるが、統計量は独立を保証するためには最小性に加えて‘常識的な’性質である完結性を持たなければならない。

典型的な結果としては、正規分布からのランダムサンプルの標本平均$\overline{X}$と標本分散$S^{2}$が独立であることが挙げられる。もちろん、これらが独立であることは、学生の定理など、バスの定理なしで示すこともできるが、やや一般的な証明法と言えるだろう。

証明 1

戦略:離散確率分布の場合のみを証明してみよう。$S \left( \mathbf{X} \right)$がパラメータ$\theta$についての補助統計量だとすると、$P \left( S \left( \mathbf{X} \right) = s \right)$は$\theta$に依存せず、十分統計量の定義により条件付き確率 $$ P \left( S \left( \mathbf{X} \right) = s \mid T \left( \mathbf{X} \right) = t \right) = P \left( \mathbf{X} \in \left\{ \mathbf{x} : S \left( \mathbf{x} \right) = s \right\} \mid T \left( \mathbf{X} \right) = t \right) $$ も$\theta$に依存しない。従って、以下を示せば十分である。 $$ P \left( S \left( \mathbf{X} \right) = s \mid T \left( \mathbf{X} \right) = t \right) = P \left( S \left( \mathbf{X} \right) = s \right) \qquad , \forall t $$

確率の加法定理により、 $$ P \left( S \left( \mathbf{X} \right) = s \right) = \sum_{t} P \left( S \left( \mathbf{X} \right) = s \mid T \left( \mathbf{X} \right) = t \right) P_{\theta} \left( T \left( \mathbf{X} \right) = t \right) $$ である。一方で、$1 = \sum_{t} P_{\theta} \left( T \left( \mathbf{X} \right) = t \right)$の両辺に$P \left( S \left( \mathbf{X} \right) = s \right)$を掛けると、 $$ \begin{align*} P \left( S \left( \mathbf{X} \right) = s \right) \cdot 1 =& P \left( S \left( \mathbf{X} \right) = s \right) \cdot \sum_{t} P_{\theta} \left( T \left( \mathbf{X} \right) = t \right) \\ =& \sum_{t} P \left( S \left( \mathbf{X} \right) = s \right) P_{\theta} \left( T \left( \mathbf{X} \right) = t \right) \end{align*} $$ である。以下のような統計量を定義してみると、全ての$\theta$に対して、 $$ \begin{align*} E_{\theta} g (T) =& \sum_{t} g(t) P_{\theta} \left( T \left( \mathbf{X} \right) = t \right) \\ =& P \left( S \left( \mathbf{X} \right) = s \right) - P \left( S \left( \mathbf{X} \right) = s \right) \\ =& 0 \end{align*} $$ である。

完結統計量の定義: $$ \forall \theta, E_{\theta} g (T) = 0 \implies \forall \theta, P_{\theta} \left( g(T) = 0 \right) = 1 $$

$T \left( \mathbf{X} \right)$は完結統計量と仮定したので、可能な全ての$t$と全ての$\theta$に対して、以下が従う。 $$ P_{\theta} \left( g(T) = 0 \right) = 1 $$ 言い換えると、以下が成り立つ。 $$ P \left( S \left( \mathbf{X} \right) = s \mid T \left( \mathbf{X} \right) = t \right) = P \left( S \left( \mathbf{X} \right) = s \right) \qquad , \forall t $$

■

Casella. (2001). Statistical Inference(2nd Edition): p287. ↩︎