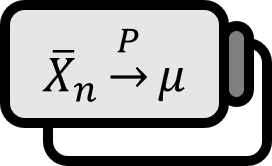

十分統計量

定義 1

$\Omega$をパラメータの集合としよう。サンプル$\mathbf{X}$の統計量$T := T \left( \mathbf{X} \right)$の確率密度関数または確率質量関数$f \left( t ; \theta \right)$を集めたファミリー$\left\{ f \left( t ; \theta \right) : \theta \in \Theta \right\}$が $$ \forall \theta, E_{\theta} g (T) = 0 \implies \forall \theta, P_{\theta} \left( g(T) = 0 \right) = 1 $$ を満たす場合、完全completeであると言い、$T \left( \mathbf{X} \right)$を完全統計量complete statisticと呼ぶ。

説明

口頭で発音するとき、補助統計量の韓国語を使う人は誰もおらず、[アンシラリー スタティスティック]と同様に、通常完全統計量も英語の発音そのまま[コンプリート スタティスティック]と言う。

注意

注意すべき点は、完全であることが特定の確率分布ではなく、分布族、つまりすべての$\theta$に対して$\left\{ f \left( t ; \theta \right) : \theta \in \Theta \right\}$を考えることであり、そのとき$T$を完全統計量と呼ぶということである。より明確に要約すると、次のようになる。

- 完全なものは分布族$\left\{ f \left( t ; \theta \right) : \theta \in \Theta \right\}$である。

- 完全統計量自体はその分布族ではなく、統計量$T$である。

しかし、要約を見ると$g$が登場しない。完全統計量の定義が掴みどころのない話に感じられる理由は、このように$g$が何であり$T$が何であるかを実際には知ることができないためである。そこに「すべての$\theta$」という表現が句点を打っている。

直感的にわかる統計量

シンプルな直感でアプローチしてみよう。期待値が$g(T)$になるようにするという説明は一旦脇に置いて、単に二つの期待値$E_{\theta} g_{1} (T)$と$E_{\theta} g_{2} (T)$が同じである状況を考えてみよう。これを積分形で表すと、 $$ \int_{\mathbb{R}} g_{1} \left( t \right) f \left( t ; \theta \right) d t = E_{\theta} g_{1} (T) = E_{\theta} g_{2} (T) = \int_{\mathbb{R}} g_{2} \left( t \right) f \left( t ; \theta \right) d t $$ [ 注:実際の計算では$T$は積分変数$dt$として意味を持ち、その統計量の本質は$f \left( t ; \theta \right)$に組み込まれている。] しかし$f \left( t ; \theta \right)$は確率密度関数なので$f \left( t ; \theta \right) \ne 0$であろうが、それにもかかわらず上の等式が成り立つということは、おそらく$g_{1}$と$g_{2}$が同じという意味であろう。もちろん$\theta$に応じて変わる確率密度関数の形に合わせて新しい$g_{1} \ne g_{2}$を選択することで等式を満たすことはできるだろうが、これがすべての$\theta$に対して常に成り立つならば、$g_{1}$と$g_{2}$には多くの選択肢がない。おそらくほとんどすべての$t$で次のことが成り立つはずである。 $$ g_{1} \left( t \right) = g_{2} \left( t \right) $$ 言い換えれば、$g_{1}$と$g_{2}$はほぼ確実に同じ関数、つまり点数が少し足りない程度で全て同じである確率が$100\% $であるということである。これを単なる数式で表すと、 $$ P_{\theta} \left( g_{1} \left( T \right) = g_{2} \left( T \right) \right) = 100 \% $$ もちろんこれは$E_{\theta} g_{1} (T) = E_{\theta} g_{2} (T)$のときの話であり、 $$ \forall \theta \in \Theta, E_{\theta} g_{1} (T) = E_{\theta} g_{2} (T) \implies \forall \theta \in \Theta , P_{\theta} \left( g_{1} \left( T \right) = g_{2} \left( T \right) \right) = 100 \% $$ だ。再び$g$に戻って$g := g_{2} - g_{1}$とすると、今までとは少し違和感のあった完全統計量の定義が得られる。このような説明を省略していきなり$g$から始める理由は、この概念を表現するために$g_{1}$と$g_{2}$が必ずしも必要ではないためである。[ 注:教科書によっては不偏推定量などと関連付けて説明することもあるが、これも完全統計量の定義自体には必要ない。] $$ \forall \theta, E_{\theta} \left[ g_{2} (T) - g_{1} (T) \right] = 0 \implies \forall \theta, P_{\theta} \left( \left[ g_{2} (T) - g_{1} (T) \right] = 0 \right) = 100 \% $$

もし$T$が完全統計量でない場合、上で簡単に述べたように$f \left( t ; \theta \right)$に大きな問題があると推測できる。何らかの$\theta$に対して驚くべきほど変動する確率密度関数$f \left( t ; \theta \right)$を持つ統計量$T$は、どう見ても非常識であると言えるだろう。

ここまでの議論を見ればわかるように、完全統計量は特に良い性質を示していない。むしろ、あまりにも当たり前で常識的だった。しかし、上記の提案である$\theta$の中でたった一つでも例外があれば、$T$はある種の当たり前で常識的な理論展開において完全に準備されていない統計量であると考えることができる。

定理

混乱したかもしれない$g, T, \theta$に関する内容を一行ずつ要約すると、次のようになる。

- $g$:正直、$0$になるはずなので、$0$以外は心配する必要がなく、とりあえず$g(t)$とする。

- $T$:一見、式から消えたように見えるが、実際には$f \left( t ; \theta \right)$そのものである。

- $\forall \theta$:たった一つの例外的な$\theta$も許さないという点で完全性completenessになる。

普遍的な完全性との関連性

少し難しい話だ。統計学にだけ関心があるなら、この部分は読み飛ばしても良い。読んで理解できたとしても、これは学界の定説ではなく、筆者の個人的な見解なので、あまり真剣に受け止めないでほしい。

数理統計ではない、普通の数学では完全性とは通常、距離空間で定義される完全性を指す。コーシー列が収束する点が元の空間に属するかどうかが数学で非常に重要であり、測度空間などの場では、コーシー列を明示的に定義せずに完全性について論じることもある。 $$ p: x \overset{?}{\triangle} X \implies q: x \in X $$ しかし、完全性について語るとき、その詳細な定義がどうであれ、$\overset{?}{\triangle}$がどのような関係であれ、条件付き命題の$q$には$x \in X$に似た何かが来る。何が違っていようと、どれほど抽象化されていようと、私たちが関心を持っている何かが元の集合に属しているということが、普遍的な完全性の形なのである。

長い間、筆者は多くの学者にこのことについて質問し、ウィキペディアを含む様々な[^2] [^3]文書を探したが、統計量の完全性とその普遍的な完全性とは正確な関連がないと結論づけた。せめて、どんな$\theta$にも例外を設けないという点で、私たちが関心を持つすべての$\theta$がパラメータの集合に入り、$\theta \in \Theta$のような言葉を作って繋げるしかない。

数式的に似ているものとしては、測度論で語られる[シグマフィ

Casella. (2001). Statistical Inference(2nd Edition): p285. ↩︎