함수를 취한 확률변수꼴 합의 기대값

정리 1

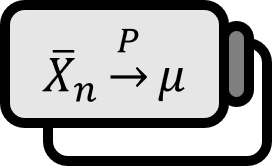

$X_{1} , \cdots , X_{n}$ 이 랜덤 샘플이고, $E g \left( X_{1} \right)$ 과 $\Var g \left( X_{1} \right)$ 가 존재하게끔 하는 함수 $g : \mathbb{R} \to \mathbb{R}$ 가 주어져 있다고 하자. 그러면 다음이 성립한다.

- [1] 평균: $$ E \left( \sum_{k = 1}^{n} g \left( X_{k} \right) \right) = n E g \left( X_{1} \right) $$

- [2] 분산: $$ \Var \left( \sum_{k = 1}^{n} g \left( X_{k} \right) \right) = n \Var g \left( X_{1} \right) $$

설명

이 정리에서 눈여겨보아야 할 부분은 $\left\{ X_{k} \right\}_{k=1}^{n}$ 이 랜덤샘플, 다시 말해 iid라는 것이다. 가령 $i \ne j$ 일 때 $X_{i} = X_{j}$ 이고 $g (x) = x$ 라면 분산의 성질에서 잘 알고 있듯 $$ \Var \left( \sum_{k=1}^{n} X_{k} \right) = \Var \left( n X_{k} \right) = n^{2} \Var X_{k} $$ 이다. 다시 말해 정리 [2]를 유도하기 위해 독립이라는 조건이 반드시 필요한 것이다.

증명

[1]

기대값은 선형성을 가지며, $X_{1} , \cdots , X_{n}$ 가 같은 분포를 따르므로 다음이 성립한다. $$ \begin{align*} & E \left( \sum_{k = 1}^{n} g \left( X_{k} \right) \right) \\ =& \sum_{k=1}^{n} E g \left( X_{k} \right) & \because \text{lineartiy} \\ =& n E g \left( X_{1} \right) & \because \text{identical distributed} \end{align*} $$

■

[2]

$X_{1} , \cdots , X_{n}$ 가 독립이므로 $i \ne j$ 이면 $\operatorname{Cov} \left( g \left( X_{i} \right) , g \left( X_{j} \right) \right) = 0$ 이다. 따라서 $$ \begin{align*} & \Var \left( \sum_{k = 1}^{n} g \left( X_{k} \right) \right) \\ =& E \left[ \sum_{k=1}^{n} g \left( X_{k} \right) - E \sum_{k=1}^{n} g \left( X_{k} \right) \right]^{2} \\ =& E \left[ \sum_{k=1}^{n} \left[ g \left( X_{k} \right) - E g \left( X_{k} \right) \right] \right]^{2} \\ =& \sum_{k=1}^{n} E \left[ g \left( X_{k} \right) - E g \left( X_{k} \right) \right]^{2} + \sum_{i \ne j} E \left[ g \left( X_{i} \right) - E g \left( X_{i} \right) g \left( X_{j} \right) - E g \left( X_{j} \right) \right] \\ =& \sum_{k=1}^{n} \Var g \left( X_{k} \right) + \sum_{i \ne j} \operatorname{Cov} \left( g \left( X_{i} \right) , g \left( X_{j} \right) \right) \\ =& n \Var g \left( X_{1} \right) + 0 \end{align*} $$ 이 성립한다.

■

Casella. (2001). Statistical Inference(2nd Edition): p213. ↩︎

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!