피셔 정보

빌드업

스코어 함수

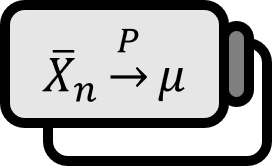

모수 $\theta \in \Theta$ 에 대해 확률밀도함수가 $f \left( x ; \theta \right)$ 인 확률변수 $X$ 를 생각해보자. 로그우도함수가 가장 커지는 추정량인 최대우도추정량은 다음과 같은 편미분방정식을 만족하는 $\widehat{\theta}$ 으로 구할 수 있었다. $$ \sum_{k=1}^{n} {{ \partial \log f \left( x_{k} ; \theta \right) } \over { \partial \theta }} = 0 $$ 여기서 $\displaystyle {{ \partial \log f ( x ; \theta ) } \over { \partial \theta }}$ 를 스코어 함수score function이라 부른다. 수식적으로 편미분의 의미를 생각해보면 이들의 값이 $0$ 에 가깝다는 것은 $\theta$ 가 변함으로써 우도함수의 변화에 끼치는 영향이 미비하다는 것이다. 그렇다면 거꾸로 $$ E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] $$ 을 계산하면 주어진 $\theta$ 가 미치는 영향력을 구체적으로 구할 수 있을 것 같다. 곱셈으로 계산되는 우도함수 $L$ 대신 덧셈으로 계산되는 로그우도함수 $l$ 을 고려하는 것은 이러한 의도도 있는데, 덧셈 계산은 자연스럽게 평균―기대값의 개념과 연결되기 때문이다. 그러나 스코어 함수의 값은 음수와 양수가 뒤섞여있기 때문에 실제로 ‘변화하는 양’을 계산하기엔 부적절하다. 이를 극복하기 위해 제곱을 생각해보자. $$ I(\theta) \overset{?}{=} E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] $$ 지금까지의 논의를 보았을 때 $I ( \theta )$ 라는 것은 앞서 설명한대로 주어진 $\theta$ 가 얼마나 정보를 주는지로 볼 수도 있겠다. 이제 이러한 꼴이 최대우도추정법의 맥락 없이도 수식적으로 도출될 수 있는지 살펴보자.

정리

바틀렛 항등식 1

영국의 통계학자 바틀렛bartlett의 이름이 붙은 바틀렛 항등식을 유도해보자.

바틀렛 항등식: 정칙조건 (R0)~(R4)를 만족한다고 하자.

- [1] 제1항등식: $$ E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] = 0 $$

- [2] 제2항등식: $$ E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) = 0 $$

정칙조건:

- (R0): 확률밀도함수 $f$ 는 $\theta$ 에 대해 단사다. 수식으로는 다음을 만족시킨다. $$ \theta \ne \theta ' \implies f \left( x_{k} ; \theta \right) \ne f \left( x_{k} ; \theta ' \right) $$

- (R1): 확률밀도함수 $f$ 는 모든 $\theta$ 에 대해 같은 서포트를 가진다.

- (R2): 참값 $\theta_{0}$ 는 $\Omega$ 의 내점interior point이다.

- (R3): 확률밀도함수 $f$ 는 $\theta$ 에 대해 두 번 미분가능하다.

- (R4): 적분 $\int f (x; \theta) dx$ 은 적분 기호를 넘나들며 $\theta$ 에 대해 두 번 미분가능하다.

유도

[1]

$$ 1 = \int_{-\infty}^{\infty} f (x ; \theta ) dx $$ 정칙조건 (R3), (R4) 에 따라 $\theta$ 에 대해 편미분하면 $$ 0 = \int_{-\infty}^{\infty} {{ \partial f ( X ; \theta ) } \over { \partial \theta }} dx $$ 적분 안에 $\displaystyle 1 = {{ f (x ; \theta ) } \over { f (x ; \theta ) }}$ 를 곱하는 트릭을 사용하고, $f$ 를 $\theta$ 에 대한 함수로 보면 로그함수의 미분법에서 $\displaystyle \log g = {{ g' } \over { g }}$ 이므로 $$ \begin{align*} 0 =& \int_{-\infty}^{\infty} {{ \partial f ( X ; \theta ) } \over { \partial \theta }} {{ f (x ; \theta ) } \over { f (x ; \theta ) }} dx \\ =& \int_{-\infty}^{\infty} f_{\theta}(x ; \theta) {{ 1 } \over { f (x ; \theta ) }} f (x ; \theta ) dx \\ =& \int_{-\infty}^{\infty} {{ f ' (x ; \theta) } \over { f (x ; \theta ) }} f (x ; \theta ) dx \\ =& \int_{-\infty}^{\infty} {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) dx \\ =& E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] \end{align*} $$

■

[2]

$$ 0 = \int_{-\infty}^{\infty} {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) dx $$

유도 [1] 중에 있었던 위 등식을 한 번 더 $\theta$ 로 편미분 해보면 곱의 미분법과 같은 트릭을 써서

$$ \begin{align*} 0 =& {{ \partial } \over { \partial \theta }} 0 \\ =& \int_{-\infty}^{\infty} {{ \partial } \over { \partial \theta }} \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) \right) dx \\ =& \int_{-\infty}^{\infty} {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} f (x ; \theta ) dx + \int_{-\infty}^{\infty} \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} f (x ; \theta ) dx \\ =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] \end{align*} $$ 항등식 [1]에 따라 양변에서 $0^{2} = E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right]^{2}$ 를 빼면 $\Var Y = E Y^{2} - \left( EY \right)^{2}$ 이므로 $$ \begin{align*} 0 - 0^{2} =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] - E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right]^{2} \\ =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) \end{align*} $$

■

정의 2

피셔 정보 $I(\theta)$ 는 다음과 같이 스코어 함수의 제곱의 기대값으로 정의된다. $$ I(\theta) := E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] $$

따름정리

바틀렛 항등식에 따라 다음이 성립한다. $$ \begin{align*} \\ I ( \theta ) =& E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] - 0^{2} \\ =& \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) \\ =& - E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] \end{align*} $$ 이에 따라 랜덤 샘플 $X_{1}, \cdots , X_{n}$ 에 대한 정보는 $$ \Var \left( {{ \partial \log L ( \theta ; \mathbf{X} ) } \over { \partial \theta }} \right) = \Var \left( \sum_{k=1}^{n} {{ \partial \log f ( X_{k} ; \theta ) } \over { \partial \theta }} \right) = n I (\theta) $$ 다시 말해, 표본의 수만큼 정보도 많아진다.

설명

빌드업의 내용을 받아들일 수 있다면 피셔 정보를 왜 저렇게 복잡하게 정의하는지에 대한 의문은 없을 것이다.

따름정리에서 피셔 정보는 스코어 함수의 분산으로도 나타날 수 있음을 보았는데, 피셔 정보가 크다는 것은 그만큼 스코어 함수가 다양하게 나오는 것이며 이는 직관적인 ‘정보량’의 개념과도 자연스럽게 연결되는 것을 확인할 수 있다.

같이보기

Hogg et al. (2013). Introduction to Mathematical Statistcs(7th Edition): p334. ↩︎

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!