불편추정량

정의 1

$\theta$ 의 추정량 $T$ 가 다음을 만족하면 $T$ 를 $\theta$ 의 불편추정량unbiased estimator이라고 한다. $$ E T = \theta $$

설명

특히 $\theta$ 에 대한 불편추정량 중 가장 분산이 작은 경우 최소분산불편추정량mimimum Variance Unbiased Estimator, MVUE이라고 한다.

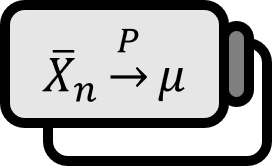

불편성이란 편의를 가지지 않는 성질을 말한다. 가령 $X_{i} \sim \left( \mu , \sigma^{2} \right)$ 라고 할 때 $\mu$ 의 추정량으로써 표본평균 $\displaystyle \overline{X} = {{ 1 } \over { n }} \sum_{i} X_{i}$ 를 사용한다면 $\displaystyle E \overline{X} = \mu$ 이므로 $\overline{X}$ 는 $\mu$ 의 불편추정량이 된다. 이는 언뜻 당연해보이지만 추정량이 모수를 정확하게 찍어준다는 것은 굉장히 중요한 성질인 동시에 당연한 일도 아니다. 예로써 분산과 표본분산을 살펴보자.

예시

$$ X_{i} \sim \left( \mu , \sigma^{2} \right) $$ 이라고 하면 분산의 불편추정량은 다음과 같다. $$ S^{2} := {{1} \over {n-1}} \sum_{i=1}^{n} \left( X_{i} - \overline{X} \right)^{2} $$ 알다시피 표본 평균과 달리 표본 분산은 편차의 제곱을 모두 더한 후 $n$ 이 아니라 $n-1$ 으로 나누어준다. 표본 분산을 구할 때 $n-1$ 으로 나누는 이유는 질문한 사람의 수준에 따라 나름의 납득이 가게끔 다른 설명을 해줄 수 있지만, 가장 정확한 수식으로 설명하자면 ‘표본 분산이 불편추정량이 되기 위해서’다.

증명 2

$$ \mu := E \overline{X} \\ \sigma^{2} := E X_{i} ^{2} - \mu^{2} $$ 이라고 하면 $$ \begin{align*} E \left( \overline{X}^{2} \right) - \mu^{2} =& E \left( \overline{X}^{2} \right) - \left( E \overline{X} \right)^{2} \\ =& \Var \overline{X} \\ =& \Var \left( {{1} \over {n}} \sum_{i=1}^{n} X_{i} \right) \\ =& {{1} \over {n^{2}}} \sum_{i=1}^{n} \Var X_{i} \\ =& {{1} \over {n^{2}}} n \sigma^{2} \\ =& {{\sigma^{2}} \over {n}} \end{align*} $$ 이므로 표본분산 $S^{2}$ 의 기대값은 $$ \begin{align*} E S^{2} =& (n-1)^{-1} E \sum_{i=1}^{n} \left( X_{i} - \overline{X} \right)^{2} \\ =& (n-1)^{-1} \left[ \sum_{i=1}^{n} E X_{i}^{2} - \sum_{i=1}^{n} E \overline{X} ^{2} \right] \\ =& (n-1)^{-1} \left[ \sum_{i=1}^{n} \left( \sigma^{2} + \mu^{2} \right) - n \left( \mu^{2} + {{\sigma^{2}} \over {n}} \right) \right] \\ =& (n-1)^{-1} \left[ n\sigma^{2} + n \mu^{2} - n \mu^{2} - \sigma^{2} \right] \\ =& (n-1)^{-1} (n-1) \sigma^{2} \\ =& \sigma^{2} \end{align*} $$

■

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!