수리통계학에서의 확률 변수의 독립

정의 1

두 확률 변수 $X_{1}, X_{2}$ 의 조인트 확률 밀도 함수 $f$ 혹은 확률 질량 함수 $p$ 에 대해 $X_{1}, X_{2}$ 의 확률 밀도 함수들 $f_{1}, f_{2}$ 혹은 확률 질량 함수 $p_{1}, p_{2}$ 가 다음을 만족하면 $X_{1}, X_{2}$ 가 독립이라 하고, $X_{1} \perp X_{2}$ 와 같이 나타낸다. $$ f(x_{1} , x_{2} ) \equiv f_{1}(x_{1})f_{2}(x_{2}) \\ p(x_{1} , x_{2} ) \equiv p_{1}(x_{1})p_{2}(x_{2}) $$

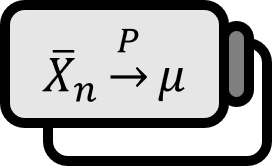

정리

아래의 정리는 이산 확률 변수에 대해서도 같지만, 편의상 연속 확률 변수인 경우만 언급한다.

다음은 모두 동치다.

- [1]: $X_{1} \perp X_{2}$

- [2] 확률 밀도 함수: $$ f (x_{1} , x_{2}) \equiv f_{1}(x_{1}) f_{2}(x_{2}) $$

- [3] 누적 분포 함수: 모든 $(x_{1} ,x_{2}) \in \mathbb{R}^{2}$ 에 대해 $$ F (x_{1} , x_{2}) = F_{1}(x_{1}) F_{2}(x_{2}) $$

- [4] 확률: 모든 상수 $a<b$ 그리고 $c < d$ 에 대해 $$ P(a < X_{1} \le b, c < X_{2} \le d) = P(a < X_{1} \le b) P ( c < X_{2} \le d) $$

- [5] 기대값: $E \left[ u (X_{1}) \right]$ 와 $E \left[ u (X_{2}) \right]$ 이 존재하고 $$ E \left[ u(X_{1}) u(X_{2}) \right] = E \left[ u (X_{1}) \right] E \left[ u (X_{2}) \right] $$

- [6] 적률 생성 함수: 조인트 적률 생성 함수 $M(t_{1} , t_{2})$ 가 존재하고 $$ M(t_{1} , t_{2}) = M (t_{1} , 0 ) M( 0, t_{2} ) $$

설명

위 동치조건들의 모양을 보면 알 수 있듯 독립이라는 것은 쉽게 말해 엉켜있는 (조인트) 함수를 곱셈꼴로 분리할 수 있는 조건을 말한다. 이는 사건의 독립이 확률을 $$ P(A \mid B) = {{ P(A B) } \over { P(B) }} \overset{\text{ind}}{\implies} P(AB) = P(A \mid B) P(B) = P(A) P(B) $$ 와 같이 분리할 수 있다는 것을 추상화한 것으로 볼 수 있다. 독립을 직관적으로 이해하는 것도 중요하지만, 수리통계학을 공부함에 있어서는 그 수식적인 모양에 더욱 신경을 쓸 필요가 있다.

같이보기

Hogg et al. (2013). Introduction to Mathematical Statistcs(7th Edition): p112. ↩︎

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!

저희들의 저서 「줄리아 프로그래밍」이 2024 세종도서 학술부문에 선정되었습니다!