信用区間と信頼区間の違い

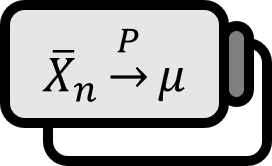

定理

信用区間と信頼区間の違いは、本質的にベイジアンとフリークエンティストの違いとみなせる。

- 信頼区間(フリークエンティスト): パラメーターは固定された定数で、信用区間がランダムに求められる。

- 信用区間(ベイジアン): パラメーターも変数として分布を持ち、信用区間も事後分布で求められる。

信頼区間

古典統計学では、あるパラメーター $\mu$ に対する $95 \% $ 信頼区間 $[a , b]$ の意味は、同じ方法で作られた信頼区間 $100$ 個があった場合、その中で $95$ 個くらいが$\mu \in [a,b]$を満たすということだ。式で簡単に表すと$p ( \mu \in [a,b] ) = 95 \% $だが、常識とは異なり、この解釈は非常に難解だ。同じ式でも、次のように異なるニュアンスで読める。

- $\mu$が$[a,b]$に含まれる確率は$95 \% $だ。(X)

- $[a,b]$が$\mu$を含む確率は$95 \% $だ。(O)

もちろん、上記の2文は同じ意味だが、読む人は文字自体ではなく、ニュアンスの違いを感じ取る必要がある。つまり、$\mu$が信頼区間 $[a , b]$に含まれる確率が$95 \% $ではなく、信頼区間を作る過程において、$95 \% $の信頼区間 $[a , b]$の中に$\mu$を含む信頼区間が全体で$95 \% $程度あるということだ。

私たちが知りたいパラメーター $\mu$自体は、分布を知ることのできない定数であり、代わりに信頼区間の上限と下限である$a,b$はその分布を知っているため、$a < \mu$であっても$ \mu < b$である場合を考えることができる。この微妙な違いのために、信頼区間は私たちの直感と完全に一致しない。だから、こうした常識的で簡単な概念を説明するにも、いくつかを作るとそのうちのいくつかは含まれるのかという抽象的な説明が必要になる。

そもそも$\mu$を基準にしてみると、$\mu$について定義された分布がないため、$p ( \mu \in [a,b] )$という表現自体が意味をなさない。だれかが$X$の分布も教えずに$P \left( 0 \le X \le 2 \right)$の値がいくつかと尋ねたら、かなり戸惑うだろうが、信頼区間に対する誤った解釈がまさにこれと同じだ。

フリークエンティストの観点からパラメーター $\mu$は変わらない定数として存在し、サンプルによって変わるのは信頼区間そのものだ。まるで現在のサンプルが母集団と似ていると仮定するように、一つの信頼区間を作り、この信頼区間がまだ作られていない残りの信頼区間と似ていると見るわけだ。

信用区間

パラメータ空間 $\Theta$ の部分集合 $C \subset \Theta$が有意水準 $\alpha$ に対して $P ( \theta \in C | y ) \ge 1 - \alpha$ を満たすとき、データ$y$が与えられた際の$\theta$に対する$100(1 - \alpha) \% $ 信用区間と呼ばれる。

一方で、信用区間はそもそも$\theta$に対する確率として定義される。それが可能なのは、パラメーター $\theta$に対して事後分布$p ( \theta | y)$を適切に仮定するからだ。これは統計学を学ぶ学生が概念的に受け入れてきた信頼/信用区間の定義と直感的に一致する。

ベイジアンはまだ得ていないサンプルなど気にしない。それは事後分布に関する仮定と、これまでに得たサンプルだけを見て出された最善の答えに過ぎない。したがって、$100$個の信用区間を作ったなら、そのうち$95 \% $程度はパラメーター $\theta$が$C$に属しているという稚拙な説明は必要ない。