混合分布

ビルドアップ1

下の図のような確率密度関数を持つ確率分布を近似したいとしよう。

確率分布を近似する基本的な方法の一つは、近似したい分布と最も似た正規分布を探すことである。しかし、次の図が示すように、我々が近似しようとする分布はピークが三つなので、正規分布でこれを適切に近似するのは難しそうだ。

ここでこう考えることができる。正規分布は一つのピークを持ち、近似したい分布は三つのピークを持つ。ならば、三つの正規分布を足して近似したい分布を近似できるのではないか?これがまさに混合分布のアイデアである。実際に上の確率密度関数は次のようになる。

$$ p(x) = \dfrac{1}{2}N(5, 1) + \dfrac{1}{4}N(-4, 1) + \dfrac{1}{4}N(0, 1.5) $$

定義

簡単な定義

確率分布の線形結合を混合分布mixture distributionという。

厳密な定義2

$k$個の確率分布の確率密度関数がそれぞれ$f_{1}, \dots, f_{k}$だとしよう。混合係数mixing coefficient $\pi_{1}, \dots, \pi_{k}$に対して、次の確率密度関数 $f$が従う分布を混合分布mixture distributionという。

$$ f(x) = \pi_{1} f_{1}(x) + \cdots + \pi_{k} f_{k}(x) = \sum_{i=1}^{k} \pi_{i} f_{i}(x) \tag{1} $$

説明

一方、$f$が確率密度関数となるためには、$\pi_{i}$は全て足すと$1$になるという条件が必要だ。簡単に示すと、$(1)$の両辺を積分すると次のようになる。

$$ \int f(x) dx = \int \left( \sum_{i=1}^{k} \pi_{i} f_{i}(x) \right) dx = \sum_{i=1}^{k} \pi_{i} \int f_{i}(x) dx = \sum_{i=1}^{k} \pi_{i} = 1 $$ $$ \implies \sum_{i=1}^{k} \pi_{i} = 1 $$

また、$f_{i} \ge 0$であるから、それぞれの$\pi_{i}$は$\pi_{i} \in [0, 1]$を満たさなければならない。

一方、$\pi_{i}$は自然に確率、重みなどとも呼ばれることができる。確率に関する解釈は文書下部の責任値単元を参照しよう。

| 混合係数 | 混合確率 | 重み |

|---|---|---|

| mixing coefficients | mixing probabilities | weights |

| $\pi_{i}$ | $p_{i}$ | $w_{i}$ |

| $\sum\limits_{i=1}^{k} \pi_{i} = 1$ | $\sum\limits_{i=1}^{k} p_{i} = 1$ | $\sum\limits_{i=1}^{k} w_{i} = 1$ |

| $0 \le \pi_{i} \le 1$ | $0 \le p_{i} \le 1$ | $0 \le w_{i} \le 1$ |

累積分布関数

確率密度関数 $f$に対応する確率変数を$X$とすると、$X$の累積分布関数 $F_{X}$は次の通りである。

$$ F_{X}(x) = \sum\limits_{i=1}^{k} \pi_{k} F_{i}(x) $$

このとき、$F_{i}$は$f_{i}$に対応する累積分布関数である。

期待値

それぞれの$f_{i}$に対応する確率変数を$X_{i}$とする。$X_{i}$の平均が$\mu_{i} = E[X_{i}]$とすると、$X$の期待値は次のようになる。

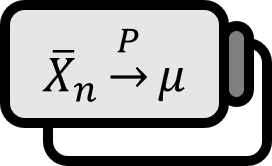

$$ \begin{align*} E[X] &= \int x f(x) dx = \int x\sum\limits_{i=1}^{k} \pi_{i}f_{i}(x)dx \\ &= \sum\limits_{i=1}^{k}\pi_{i} \int x f_{i}(x)dx = \sum\limits_{i=1}^{k}\pi_{i}\mu_{i} \\ &= \mu \end{align*} $$

再度いうと、$\mu = E[X]$は$\mu_{i}$の加重平均である。

分散

$X$の分散は次のようになる。

$$ \begin{align*} &\Var(X) \\ &= \int (x - \mu)^{2} f(x) dx = \int (x - \mu)^{2} \sum\limits_{i=1}^{k} \pi_{i}f_{i}(x)dx \\ &= \sum\limits_{i=1}^{k}\pi_{i} \int (x - \mu)^{2} f_{i}(x)dx \\ &= \sum\limits_{i=1}^{k}\pi_{i} \int \big[(x - \mu_{i}) + (\mu_{i} - \mu) \big]^{2} f_{i}(x)dx \\ &= \sum\limits_{i=1}^{k}\pi_{i} \left[ \int (x - \mu_{i})^{2} f_{i}(x)dx + 2(\mu_{i} - \mu) \int (x - \mu_{i}) f_{i}(x)dx \right. \\ &\qquad \qquad + \left. \int (\mu_{i} - \mu)^{2} f_{i}(x)dx \right] \\ &= \sum\limits_{i=1}^{k}\pi_{i} \int (x - \mu_{i})^{2} f_{i}(x)dx + \sum\limits_{i=1}^{k}\pi_{i} (\mu_{i} - \mu)^{2} \int f_{i}(x)dx \end{align*} $$

最後の等号は交差項で$\int (x - \mu_{i}) f_{i}(x)dx = 0$になるため成立する。式を更に整理すると次のようになる。

$$ \Var(X) = \sum\limits_{i=1}^{k}\pi_{i} \sigma_{i}^{2} + \sum\limits_{i=1}^{k}\pi_{i} (\mu_{i} - \mu)^{2} $$

このとき、$\sigma_{i}^{2}$は$X_{i}$の分散である。

責任値

$$ \begin{array}{c} \sum\limits_{i=1}^{k} \pi_{i} = 1 \\[1em] \pi_{i} \ge 0 \quad \forall i \end{array} $$

$\pi_{i}$が満たすべき性質が確率のそれと同じであるため、これを確率として解釈することができ、この場合は混合確率mixing probabilityという。$f(i) = \pi_{i}$を$i$番目の成分が選ばれる事前確率密度とみなすなら、$f_{i}(x)$を次のように$i$が与えられたときの条件付き確率密度とみなすことができる。

$$ f_{i}(x) = f(x | i) $$

すると、事後確率密度 $f(i | x)$はベイズの定理に従って次のようになり、$\gamma_{i}$を責任値responsibilityという。

$$ \begin{align*} \gamma_{i}(x) &= f(i | x) \\ &= \dfrac{f(i) f(x | i)}{\sum\limits_{j=1}^{k} f(j) f(x | j)} \\ &= \dfrac{f(i) f(x | i)}{f(x)} \end{align*} $$