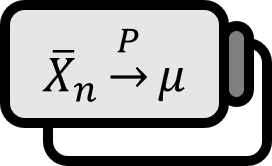

最小十分統計量が与えられた偏りのない推定量の分散は最小化される

定理 1

パラメーター $\theta$ が与えられたとしよう。$U$ は不偏推定量、$T_{1}$ は十分統計量で、$T_{2}$ は最小十分統計量で以下のように $$ \begin{align*} U_{1} :=& E \left( U | T_{1} \right) \\ U_{2} :=& E \left( U | T_{2} \right) \end{align*} $$ 定義されると、以下が成立する。 $$ \Var U_{2} \le \Var U_{1} $$

説明

$U$ が不偏推定量であるため、$T_{1}$ が与えられても $T_{2}$ が与えられても、期待値で $\theta$ を指すが、大雑把に言えば、最小十分統計量が与えられたとき、より揺れずに指すと受け止めていい。十分統計量の最小性から不偏推定量の分散の最小性が導かれると理解すると覚えやすい。

証明

最小十分統計量の定義: 十分統計量 $T \left( \mathbf{X} \right)$ が、他のすべての十分統計量 $T ' \left( \mathbf{X} \right)$ に対して $T \left( \mathbf{x} \right)$ が $T ' \left( \mathbf{x} \right)$ の関数として表される場合、$T \left( \mathbf{X} \right)$ は最小十分統計量minimal Sufficient statisticと呼ばれる。

最小十分統計量の定義により、$T_{2}$ が $T_{1}$ の関数として表されるので、 $$ \begin{align*} E \left( U_{1} | T_{2} \right) =& E \left( E \left( U | T_{1} \right) | T_{2} \right) \\ =& E \left( U | T_{2} \right) \\ =& U_{2} \end{align*} $$

条件付き分散の性質: $$ \Var(X) = E \left( \Var(X | Y) \right) + \Var(E(X | Y)) $$

条件付き分散の性質に従って、$U_{1}$と$T_{2}$に対して

$$ \begin{align*} \Var U_{1} =& E \Var \left( U_{1} | T_{2} \right) + \Var E \left( U_{1} | T_{2} \right) \\ =& E \Var \left( U_{1} | T_{2} \right) + \Var U_{2} \end{align*} $$

となる。これは任意の十分統計量 $T_{1}$ について成立するので、最小十分統計量 $T_{2}$ が与えられた場合の不偏推定量 $U$ の期待値の分散は最小となる。

■

Casella. (2001). Statistical Inference(2nd Edition): p305. ↩︎