モーメント法

定義 1

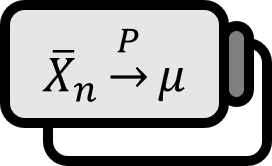

与えられた分布のパラメーターを知らない場合に、モーメントを利用してパラメーターに関する連立方程式を作り、その解をパラメーターの推定値とみなす方法をモーメントメソッドmoment methodと言う。

説明

モーメントメソッドは、1800年代からカール・ピアソンKarl Pearsonなどによって長らく使用されている点推定技術である。多くの場合で非常に良い結果を出さないことも多いが、最も単純で簡単なアプローチであるため、どんな研究をするにしても最初に試す価値がある。

例:犯罪率

二項分布 $B \left( k, p \right)$ に従うランダムサンプル $X_{1} , \cdots , X_{n}$ が与えられているとしよう。二項分布は、$k$ と $p$ が与えられた状況では非常に簡単かつ簡明に分析できるが、我々は $k$ と $p$ を知らずにデータだけが与えられた状況を考えてみよう。これは例えば犯罪率crime rate、特に性犯罪のように犯行があったにも関わらず報告されなかったケースを考慮する場合に応用できる。$k$ を全事件数とし、$p$ を報告する確率と仮定すると、各事件は報告されたか($p$) されなかったか($1-p$) の確率により、報告された事件数は実際の報告データが従う分布、すなわち二項分布 $B \left( k, p \right)$ として理解できる。

我々は、$1$ 次モーメントが平均に、$2$ 次モーメントが分散に関連していることを知っている。それに従って連立方程式を作ると、 $$ \begin{align*} m_{1} := {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} =& kp \\ m_{2} := {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i}^{2} =& kp(1-p) + k^{2} p^{2} \end{align*} $$ を得る。連立方程式を解くと、$p$ の推定値 $\hat{p}$ は $k$ の推定値 $\hat{k}$ に対して、 $$ \hat{p} = {{ 1 } \over { k }} {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} = {{ \overline{X} } \over { \hat{k} }} $$ であり、$\hat{k}$ は $$ \begin{align*} & {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i}^{2} = kp(1-p) + k^{2} p^{2} \\ \implies & {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i}^{2} = {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} \cdot (1-p) + \left( {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} \right)^{2} \\ \implies & {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i}^{2} = {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} \cdot \left( 1 - {{ \overline{X} } \over { \hat{k} }} \right) + \left( {{ 1 } \over { n }} \sum_{i=1}^{n} X_{i} \right)^{2} \\ \implies & m_{2} = m_{1} \left( 1 - {{ m_{1} } \over { \hat{k} }} \right) + m_{1}^{2} \\ \implies & {{ \left( m_{2} - m_{1}^{2} \right) } \over { m_{1} }} = 1 - {{ m_{1} } \over { \hat{k} }} \\ \implies & {{ m_{1} } \over { \hat{k} }} = {{ m_{1} - \left( m_{2} - m_{1}^{2} \right) } \over { m_{1} }} \\ \implies & \hat{k} = {{ m_{1}^{2} } \over { m_{1} - \left( m_{2} - m_{1}^{2} \right) }} \end{align*} $$ つまり、 $$ \hat{k} = {{ \overline{X}^{2} } \over { \overline{X}^{2} - \sum \left( X_{i} - \overline{X} \right)^{2} / n }} $$ となる。これはかなり使える推定値だが、分母が負になったり $0$ に近くなるとブローアップblow upするため使いにくくなる可能性がある。式を見ると、分母に問題が生じるのは(i)データ自体が小さすぎるため、$\overline{X}^{2}$ も小さすぎる場合、または(ii)分散が高すぎるため、$\sum \left( X_{i} - \overline{X} \right)^{2}$ も大きすぎる場合である。これは統計的直感と大きく反するわけではなく、欠点ではあるが納得できる欠点だと言える。

Casella. (2001). Statistical Inference(2nd Edition): p312. ↩︎