フィッシャー情報

ビルドアップ

スコア関数

パラメータ $\theta \in \Theta$ に対する確率密度関数が $f \left( x ; \theta \right)$ である確率変数 $X$ を考えよう。対数尤度関数が最大になる推定量である最尤推定量は、以下の偏微分方程式を満たす $\widehat{\theta}$ として求められた。 $$ \sum_{k=1}^{n} {{ \partial \log f \left( x_{k} ; \theta \right) } \over { \partial \theta }} = 0 $$ ここで $\displaystyle {{ \partial \log f ( x ; \theta ) } \over { \partial \theta }}$ を スコア関数score functionと呼ぶ。偏微分の数学的意味を考えると、これらの値が $0$ に近いということは、 $\theta$ の変化が尤度関数の変化に与える影響が僅かであることを意味する。それなら逆に $$ E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] $$ で計算すると、与えられた $\theta$ の影響力を具体的に求めることができそうだ。乗算で計算される尤度関数 $L$ の代わりに加算で計算される対数尤度関数 $l$ を考えるのは、加算計算が自然に平均―期待値の概念と結びつくからである。しかし、スコア関数の値にはマイナスとプラスが混ざっているため、実際に「変化する量」を計算するには不適切である。これを克服するために、二乗を考えよう。 $$ I(\theta) \overset{?}{=} E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] $$ これまでの議論を見ると、 $I ( \theta )$ は前に説明したように、与えられた $\theta$ がどれだけ情報を与えるかとも見ることができる。これからこのような形が、最尤推定方法の文脈なしにも数学的に導出することができるのか見てみよう。

定理

###バートレットの恒等式 1

イギリスの統計学者 バートレットbartlettの名前が付けられた バートレットの恒等式を導出してみよう。

バートレットの恒等式: 正則条件 (R0)~(R4)が満たされているとする。

- [1] 第1の恒等式: $$ E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] = 0 $$

- [2] 第2の恒等式: $$ E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) = 0 $$

正則条件:

- (R0): 確率密度関数 $f$ は $\theta$ に対して単射である。数式では次を満たす。 $$ \theta \ne \theta ' \implies f \left( x_{k} ; \theta \right) \ne f \left( x_{k} ; \theta ' \right) $$

- (R1): 確率密度関数 $f$ はすべての $\theta$ に対して同じサポートを持つ。

- (R2): 真の値 $\theta_{0}$ は $\Omega$ の内点interior pointである。

- (R3): 確率密度関数 $f$ は $\theta$ に対して二回微分可能である。

- (R4): 積分 $\int f (x; \theta) dx$ は積分記号を超えて $\theta$ に対して二回微分可能である。

導出

[1]

$$ 1 = \int_{-\infty}^{\infty} f (x ; \theta ) dx $$ 正則条件 (R3), (R4) に従って $\theta$ に関して微分すると $$ 0 = \int_{-\infty}^{\infty} {{ \partial f ( X ; \theta ) } \over { \partial \theta }} dx $$ 積分内に $\displaystyle 1 = {{ f (x ; \theta ) } \over { f (x ; \theta ) }}$ を掛けるテクニックを使い、 $f$ を $\theta$ の関数として見ると、対数関数の微分法から $\displaystyle \log g = {{ g' } \over { g }}$ となるため $$ \begin{align*} 0 =& \int_{-\infty}^{\infty} {{ \partial f ( X ; \theta ) } \over { \partial \theta }} {{ f (x ; \theta ) } \over { f (x ; \theta ) }} dx \\ =& \int_{-\infty}^{\infty} f_{\theta}(x ; \theta) {{ 1 } \over { f (x ; \theta ) }} f (x ; \theta ) dx \\ =& \int_{-\infty}^{\infty} {{ f ' (x ; \theta) } \over { f (x ; \theta ) }} f (x ; \theta ) dx \\ =& \int_{-\infty}^{\infty} {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) dx \\ =& E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right] \end{align*} $$

■

[2]

$$ 0 = \int_{-\infty}^{\infty} {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) dx $$

導出 [1] の中で、上記の式をもう一度 $\theta$ で偏微分してみると、積の微分法と同じテクニックを使って

$$ \begin{align*} 0 =& {{ \partial } \over { \partial \theta }} 0 \\ =& \int_{-\infty}^{\infty} {{ \partial } \over { \partial \theta }} \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} f (x ; \theta ) \right) dx \\ =& \int_{-\infty}^{\infty} {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} f (x ; \theta ) dx + \int_{-\infty}^{\infty} \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} f (x ; \theta ) dx \\ =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] \end{align*} $$ 恒等式 [1] に従って、両辺から $0^{2} = E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right]^{2}$ を引くと $\Var Y = E Y^{2} - \left( EY \right)^{2}$ となるため $$ \begin{align*} 0 - 0^{2} =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] - E \left[ {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right]^{2} \\ =& E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] + \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) \end{align*} $$

■

定義 2

フィッシャー情報 $I(\theta)$ は、次のようにスコア関数の二乗の期待値として定義される。 $$ I(\theta) := E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] $$

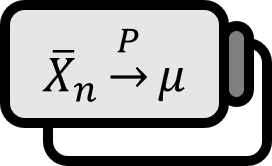

##系

バートレットの恒等式により、次が成り立つ。 $$ \begin{align*} \\ I ( \theta ) =& E \left[ \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right)^{2} \right] - 0^{2} \\ =& \Var \left( {{ \partial \log f ( X ; \theta ) } \over { \partial \theta }} \right) \\ =& - E \left[ {{ \partial^{2} \log f ( X ; \theta ) } \over { \partial \theta^{2} }} \right] \end{align*} $$ それにより、ランダムサンプル $X_{1}, \cdots , X_{n}$ に対する情報は $$ \Var \left( {{ \partial \log L ( \theta ; \mathbf{X} ) } \over { \partial \theta }} \right) = \Var \left( \sum_{k=1}^{n} {{ \partial \log f ( X_{k} ; \theta ) } \over { \partial \theta }} \right) = n I (\theta) $$ つまり、サンプルの数だけ情報も増える。

解説

ビルドアップの内容を受け入れることができれば、なぜフィッシャー情報をそんなに複雑に定義するのかについての疑問はないはずだ。

その系で、フィッシャー情報がスコア関数の分散として表されうることが見られたが、フィッシャー情報が大きいということは、スコア関数が多様に出現することを意味し、これは直感的な「情報量」の概念とも自然に繋がっていることが確認できる。

参照

Hogg et al. (2013). Introduction to Mathematical Statistcs(7th Edition): p334. ↩︎